近期,杭州深度求索人工智能基础技术研究有限公司正式发布了其最新研发的高性能AI推理模型——DeepSeekR1。该模型在数学、代码和自然语言推理等任务上表现卓越,性能直接对标OpenAI的o1正式版,同时以开源形式向全球开发者开放,并使用MIT协议开源,支持免费商用,无需申请授权,为LLM大模型开源世界又补给了满满一仓库弹药。

DeepSeek R1的核心优势

DeepSeek R1的最大亮点在于其通过强化学习(RL)技术显著提升了模型的推理能力,且仅需极少量标注数据即可实现高效训练。与OpenAI的o1相比,R1在多个基准测试中表现优异,同时价格仅为o1的几十分之一,具有极高的性价比。

- 强化学习驱动的推理能力

R1在后训练阶段大规模应用了强化学习技术,无需依赖大量监督微调(SFT)数据,即可显著提升模型的推理能力。这一创新方法不仅降低了训练成本,还使模型在复杂任务中表现出色。 - 长链推理与模型蒸馏

R1采用了长链推理(Chain-of-Thought, CoT)技术,能够逐步分解复杂问题,并通过多步骤逻辑推理解决问题。此外,R1支持模型蒸馏,开发者可以将其推理能力迁移到更小型的模型中,满足特定场景需求。 - 开源与灵活的许可证

R1遵循MIT License开源协议,允许用户自由使用、修改和商用。同时,DeepSeek还开源了R1-Zero和多个蒸馏后的小模型,进一步推动了AI技术的普及与创新。

各项性能指标更是和OpenAI-o1 模型不相上下,甚至做到了小部分的超越,关键是开源的,我们可以本地部署使用!

1、本地部署

官网:https://ollama.com/

模型:https://ollama.com/library

Github:https://github.com/ollama/ollama

Docker:https://hub.docker.com/r/ollama/ollama/tags

我们这里使用Ollama来进行模型部署,安装你的系统对应的客户端

安装Ollama

Ollama 官方版:ollama.com/

部分地区对github有访问限制,无法连接的多试几次。也可以使用docker方式安装,本次站长使用的就是docker部署

安装docker和设置镜像加速看以前的文章。

Docker方式部署

#拉取镜像

docker pull ollama/ollama:latest

# 2.创建容器(需要映射目录,比如我这linux是:/data/ollama,windows端也是一样比如D:\ollama)

mkdir -p /data/ollama

docker run -d -v /data/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

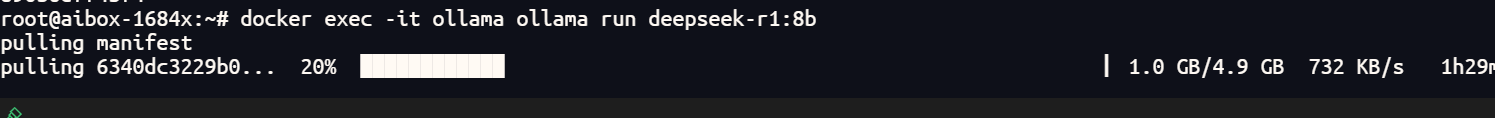

# 3.下载模型 llama3.1:8b

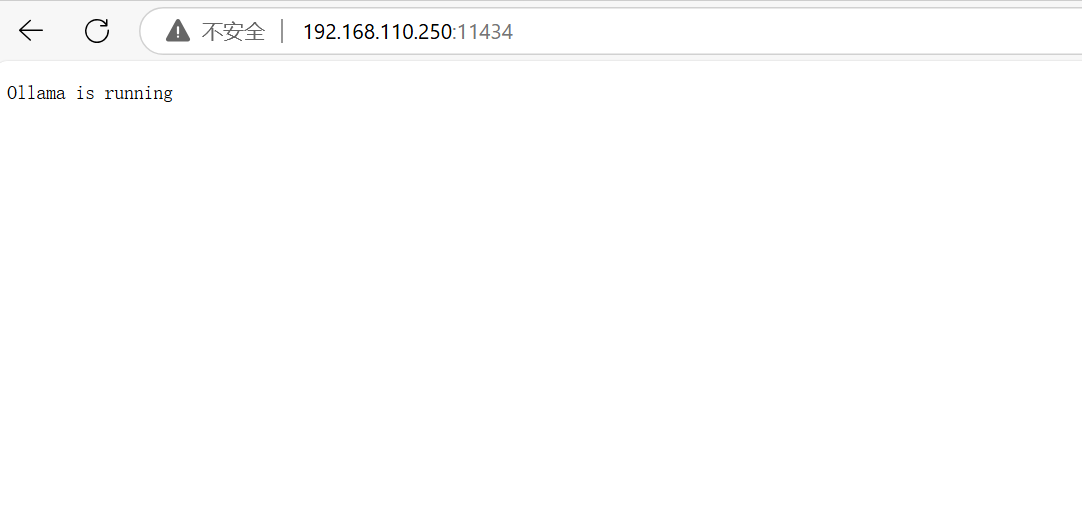

docker exec -it ollama ollama run deepseek-r1:8b完成第2步后,打开浏览器,访问 http://localhost:11434 ,可以看到 Ollama is running 在运行了。

运行第3步后,等待模型下载完成,就直接可以使用该模型聊天了。(第一次没有该模型会自动下载该模型,如果提示rror: pull model manifest: Get “https://registry.ollama.ai/v2/library/deepseek-r1/manifests/*”: dial tcp: lookup registry.ollama.ai on 223.5.5.5:53: read udp 172.17.0.2:36203->223.5.5.5:53: i/o timeout则是dns解析问题,修改本地网络的dns服务器即可)模型下载会很慢,部分地区可能会下载两三个小时,耐心等待一下。

在模型页面上可以查看自己需要下载的模型。

在模型页面上可以查看自己需要下载的模型。

模型对应硬件需求

如果使用 4-bit 量化,显存需求:

- 1.5B:约 1 GB

- 7B:约 4 GB

- 8B:约 4.5 GB

- 14B:约 8 GB

- 32B:约 18 GB

- 70B:约 40 GB

- 对于资源有限的用户,推荐使用 1.5B 或 7B 模型,它们可以在单张消费级显卡上运行。

- 如果需要更高的性能,可以选择 14B 或 32B 模型,但需要多 GPU 配置。

- 70B 模型适合高端计算环境,需要多张高端 GPU 支持。

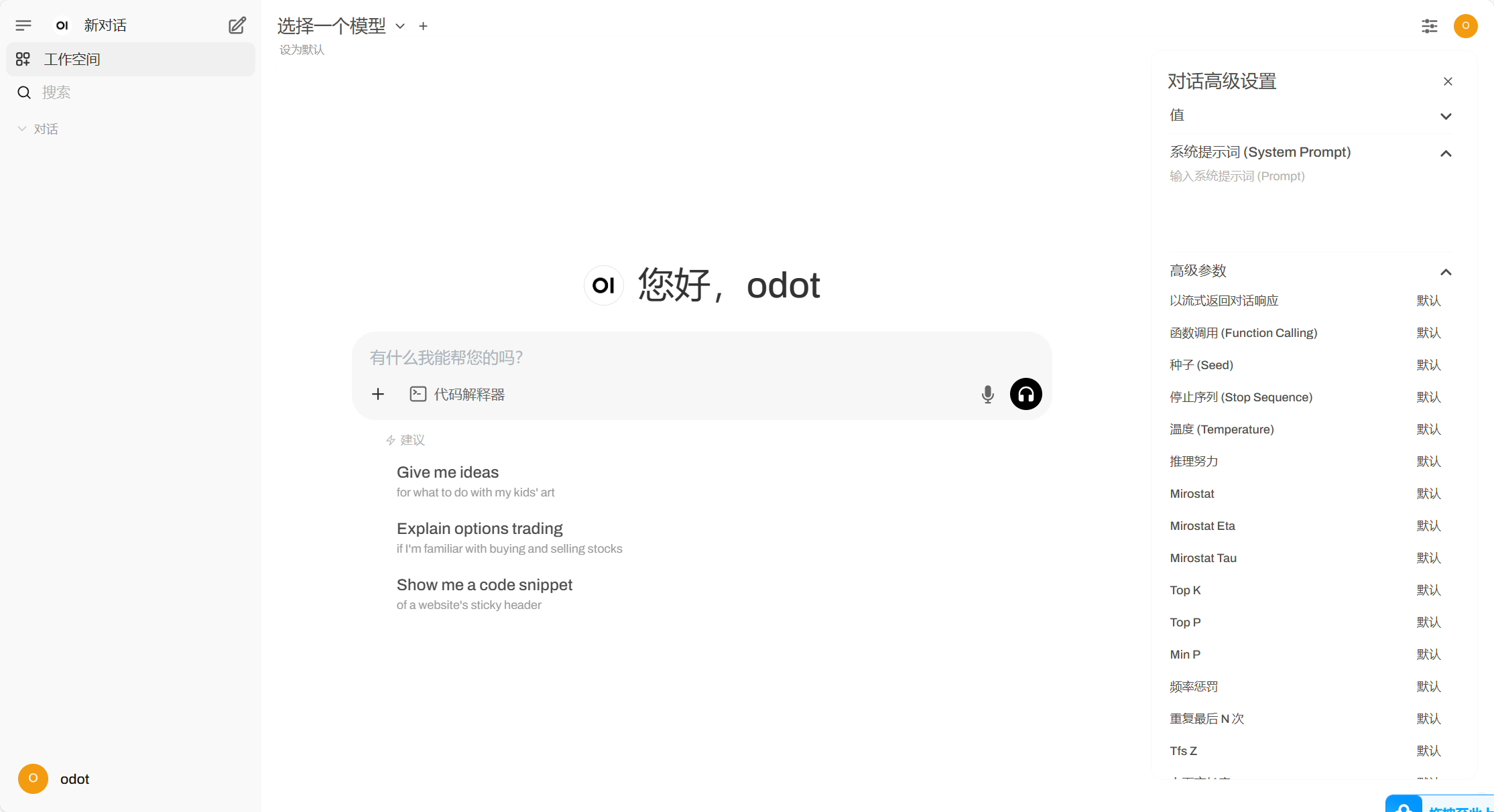

安装UI控制端

为了更方便使用我们安装一个控制端,也可以使用其他的,站长使用的是open-webui

Open WebUI 是一种可扩展的、功能丰富且用户友好的自托管 WebUI,旨在完全离线运行。它支持各种LLM运行器,包括 Ollama 和与 OpenAI 兼容的 API。

Github:https://github.com/open-webui/open-webui

文档:https://docs.openwebui.com/

# 1.拉取镜像

docker pull dyrnq/open-webui:main 或 docker pull ghcr.io/open-webui/open-webui:ollama

# 2.创建容器(需要映射目录,比如我是:/data/open-webui,映射的端口我这是3000,windows映射比如:D:\open-webui)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v/data/open-webui:/app/backend/data --name open-webui --restart always dyrnq/open-webui:main要运行支持 Nvidia GPU 的 Open WebUI,请使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda与 Ollama 捆绑的 Open WebUI,

此安装方法使用将 Open WebUI 与 Ollama 捆绑在一起的单个容器映像,从而允许通过单个命令简化设置。根据你的硬件设置选择合适的命令:

- 支持 GPU: 通过运行以下命令来利用 GPU 资源:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama - 适用于 CPU: 如果您未使用 GPU,请改用以下命令:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

这两个命令都有助于 Open WebUI 和 Ollama 的内置轻松安装,确保可以快速启动并运行所有内容。

安装后,可以访问 http://ip:3000。享受ai带来的便利!

附上windows端docker的下载连接,用docker方式搭建比较简单。

docker-desktop:docker for windows 官网下载慢的也可以用国内镜像源 阿里云dockers镜像

百度网:docker for windows 提取码:pjbw

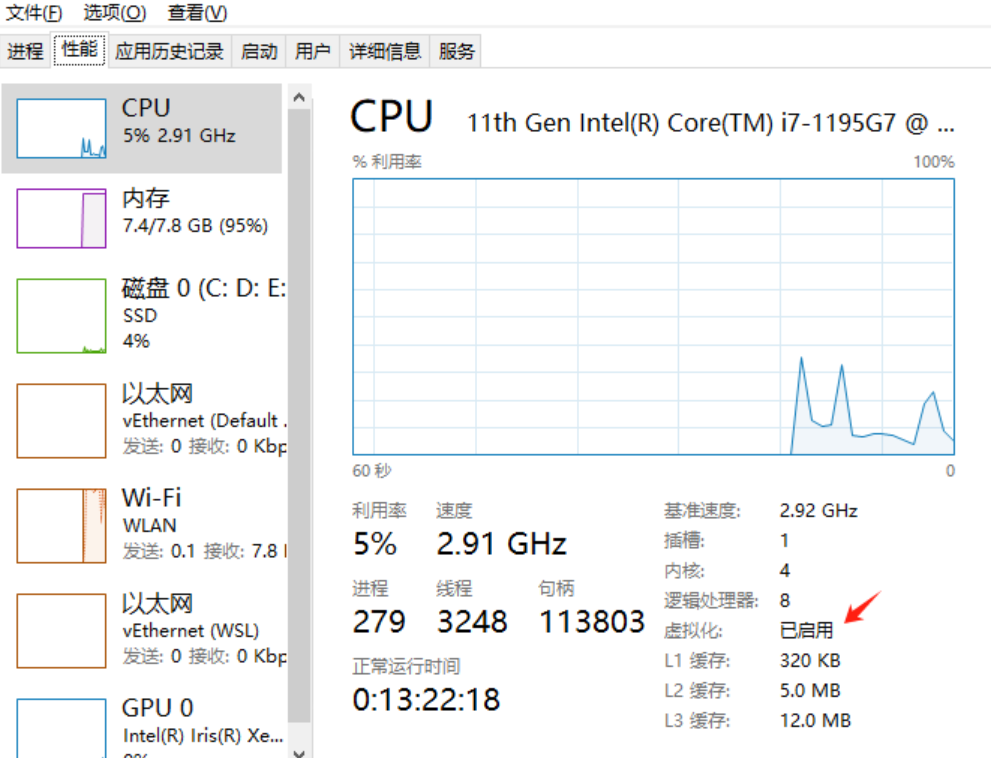

windows安装docker需要打开hyper-v

重要提示

源码工具资源类要求技术能力: 源码工具对技术要求较高,不建议小白购买下载,建议具有一定思考和动手能力的用户购买。 请谨慎考虑: 小白和缺乏思考动手能力者不建议赞助。本站只收集整理资源,部分源码不一定能运行。有空会测试部分源码及修改,赞助前请谨慎! 虚拟商品购买须知: 虚拟类商品具有可复制性,一经打赏赞助,不支持退款。请谅解,谢谢合作!

![x10070 正版分流]黑神话:悟空 Black Myth:Wukong v1.0.7.14712 赠修改器 附各种功能、各种CT表、各种存档、武器包、人物、装备替换等71+MOD合集!-飞星(官中)-旭达资源网](https://www.xusdd.com/wp-content/uploads/2024/08/down-148-1024x768.jpg)

暂无评论内容